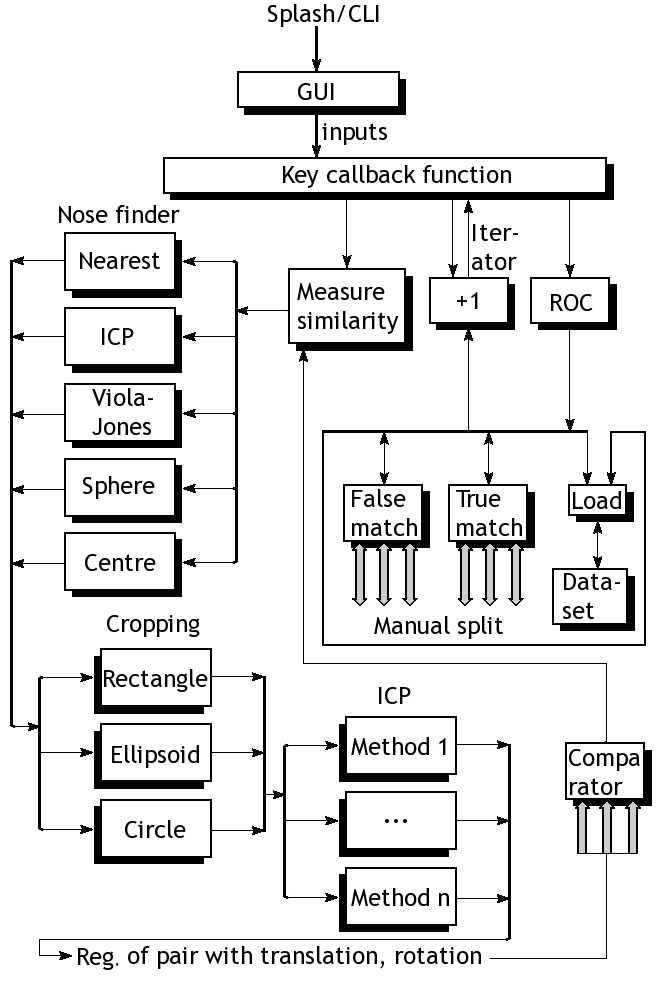

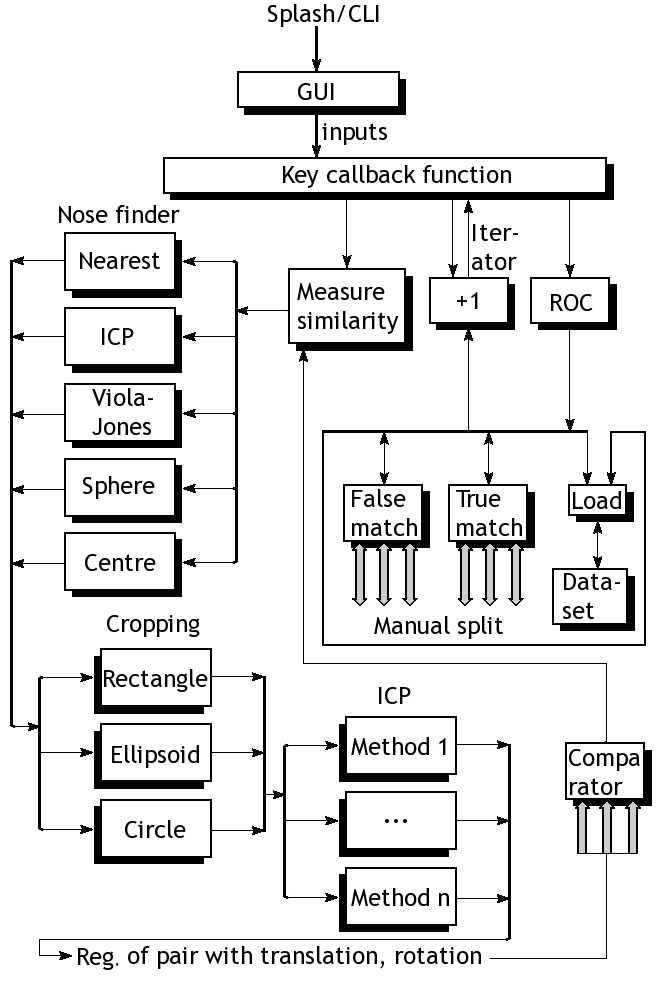

Diagrama de bloquesRepresentación del marco para la detección y clasificación de datos 3-D, tales como caras o los órganos internos, así como la evaluación comparativa

Diagrama de bloquesRepresentación del marco para la detección y clasificación de datos 3-D, tales como caras o los órganos internos, así como la evaluación comparativa

(

ODF |

PDF |

English/original)

Resumen: Personal análisis del por qué el software es una simbiosis de las matemáticas

Este artículo es un breve resumen de algo que he estado trabajando en (el código fuente será cargado en una fecha posterior cuando lo ponga en orden). La figura en la parte superior muestra al detalle nuestro marco actual, que básicamente representa un programa como un conjunto de cajas negras. Cada caja sólo realiza operaciones matemáticas con matrices volumétricas. Es, simplemente matemáticas. También se puede especificar con más precisión usando ecuaciones (sin necesidad de explicación mediante código o pseudo-código). En aras de la simplicidad, el diagrama de bloques contiene sólo los componentes básicos que se utilizan, independientemente del enfoque de pruebas. Los cargadores de archivos, por ejemplo, se muestran por separado. Trabajan muy bien y elegantemente pueden cargar conjuntos de datos basado en un selector de datos. Con la excepción de los conjuntos de prueba que son pequeños (restos de depuración), hay seis familias de los datos, algunos agrupados en pares, algunos agrupados por formación y destino, algunas nuestro laboratorio, los datos oficiales administrativos de forma aislada, otros para los datos FRGC (Gran Desafío de Reconocimiento de Caras) del NIST (Instituto Nacional de Normas y Tecnología)). También hay coincidencias correctas e incorrectas de forma aislada. Estos simplificar el trazado de las curvas ROC (Característica de Funcionamiento del Receptor) de una manera simplificada en gran medida. El objetivo del programa es poner a prueba nuevas métricas que se pueden utilizar para analizar cualquier cosa elástica como el tejido. Tiene usos en el análisis cardíaco, el cerebro, e incluso caras (he tratado con cada uno de estos tipos de datos). Para cuantiles grandes volúmenes de datos en 3-D, 70 GB de datos de cara se usan.

La parte de investigación sobre la nariz puede también ser tratada como un componente que proporciona la forma de orientación o segmentación (puede ser una cara o un órgano interno que queremos para modelar y realizar un diagnóstico en binario). Dependiendo de los conjuntos de datos, se utilizan diferentes métodos. Comúnmente, los datos FRGC son mejor interpretados por encontrar el punto más cercano, con excepción de ruido. Para los datos del laboratorio, , es preferible elegir el punto más cercano dentro de una región determinada (generalmente alrededor del centro, sin ponderación/puntuación basado en la ubicación a pesar de que también funcionaría). Esto también se puede usando IPC, como se describe más adelante (valores heredados de otra caja o módulo) o un enfoque Viola-Jones con la cara de plantillas para la formación, aunque estan sólo parcialmente implementadas hasta el momento. Esfera intersección con el plano, según Mian et al. (Con regulador independiente para radio), es otra opción existente, pero no parece superar a los métodos más simples, que trabajan la mayor parte del tiempo dado algunos límites razonables (por ejemplo, límites de esquivar la región del cabello).

Una vez identificada la punta de la nariz correctamente, estamos cosechando lo que queda para aislar las zonas rígidas. Es muy personalizable. Varios métodos de separación y los tipos límite como el círculo, elipsoide, y el rectángulo se han probado, en donde el círculo es el más comúnmente usado ya que funciona en conjunción con máscaras binarias. Estos vienen con muchos controles deslizantes y las medidas de uso en X e Y para estimar las distancias físicas reales y factorizar unidades de espacio en píxeles, por consiguiente. También hay un control deslizante para ajustar el manual adicional. Y aún así, todos ellos son matemáticas.

Hay algunos otros trozos de operación que son dignas de mención; dejado fuera el diagrama con el fin de reducir el desorden hay alisadores, removedores de agujeros, eliminadores de afloramiento, y el redondeo de los valores, los cuales son opcionales y dependen en gran medida los datos a mano y cómo debe ser tratados. Por ejemplo, los datos FRGC casi no requiere ningún suavizamiento. Los datos del laboratorio tiene las compensaciones que deben ser manejados de forma sistemática en función del número de la imagen. De hecho, ambos conjuntos de datos necesita una gran cantidad de ramas/bifurcación en el código como su manejo e incluso su tamaño varía (el programa está diseñado para manejar cualquier lado de la imagen con cualquier relación de aspecto, pero para que sub-regiones sean definidas utiliza absoluta y no relativa coordinadas entradas).

Entonces llegamos a la parte clave, que en realidad hace más que contribuir a las medidas de similitud. ICP (Puntos Iterativos Más Cercanos) es muy importante en el caso que la alineación inicial de la nariz se considera incorrecta o las caras inclinadas son. En la práctica, suponiendo que las caras son de carácter prospectivo y no inclinadas ni a los lados o el fondo de arriba, el ICP no debe cambiar mucho. Los métodos ya disponibles son el método Mian de principios de la IPC, el Mian método IPC más reciente, el Raviv método de IPC de principios de 2008, y el Raviv/Rosman método ICP de los últimos meses o años. El programa opcionalmente aplica la traducción y opcionalmente aplica la rotación también. En muchos casos esto no es necesario ya que la IPC apenas modifica algo sustancial.

La parte del modelo no está incluido en el diagrama, ya que hay muchas cosas diferentes se puede hacer con un modelo. PCA (Principal Componente Analysis), construcción de modelos, la evaluación del modelo, cargadores de archivo para modelos (cerca de 2 gigabytes para algunos), además de medidas más básicos sobre los que se aplica la evaluación, son básicamente, todo tipo de comparación que producen un valor para cada par, a continuación, proceder a el trazado de las curvas de ROC (en su mayoría automática siguiendo el diseño experimental).

Todo lo anterior es sólo matemáticas. Todo puede ser descrita mediante ecuaciones. Patentar tales cosas, sería reclamar un monopolio de las ecuaciones, lo que significa el monopolio cubre una amplia gama (incluso infinita) de las implementaciones. €¿Cómo puede alguien defender el argumento de que el software no es matemáticas? €¿O que, el software "innovativo" es de alguna manera la excepción? Si las ecuaciones ya son muchas patentadas, €¿cómo se supone que uno haga código "seguro"? €¿Cómo pueden los métodos existentes mejorar sin una violación?

Notas del Traductor:

Un par de links que podrán ayudar a nuestros lectores Hispanos a encontrar mayor información:

http://www.face-rec.org/algorithms/

http://www.nist.gov/index.html ⬆

Translation produced by Eduardo Landaveri, the esteemed administrator of the Spanish portal of Techrights.